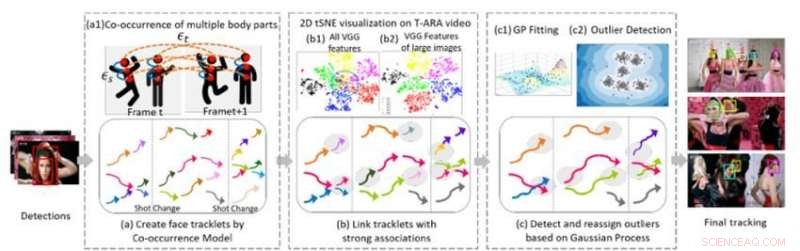

Figura 1. Tres componentes algorítmicos centrales de nuestro método para el seguimiento de múltiples caras en una secuencia de video. Crédito:IBM

En la reciente Conferencia de 2018 sobre Visión por Computador y Reconocimiento de Patrones, Presenté un nuevo algoritmo para el seguimiento de múltiples caras, un componente esencial para comprender el video. Para comprender las secuencias visuales que involucran a personas, Los sistemas de inteligencia artificial deben poder rastrear a varios individuos a través de escenas, a pesar de cambiar los ángulos de la cámara, Encendiendo, y apariencias. El nuevo algoritmo permite a los sistemas de IA realizar esta tarea.

El trabajo anterior en esta área se ha centrado en gran medida en el seguimiento de una o varias personas dentro de una toma. El siguiente paso es rastrear a varias personas a lo largo de un video completo que consta de muchas tomas diferentes. Esta tarea es desafiante porque las personas pueden salir y volver a ingresar al video repetidamente. Sus apariencias pueden cambiar drásticamente gracias al vestuario, peinado, y maquillaje. Sus poses cambian, y sus caras pueden estar parcialmente ocluidas por el ángulo de visión, Encendiendo, u otros objetos en la escena. El ángulo de la cámara y el zoom también cambian. y características como mala calidad de imagen, mala iluminación, y el desenfoque de movimiento puede aumentar la dificultad de la tarea. Las tecnologías de reconocimiento facial existentes pueden funcionar en casos más limitados, donde las imágenes son de buena calidad y muestran la cara completa de una persona, pero fallan en un video sin restricciones, donde las caras de las personas pueden estar de perfil, ocluido, recortado o borroso.

Un método para el seguimiento de múltiples caras

Colaborando con el profesor Ying Hung, del Departamento de Estadística y Bioestadística de la Universidad de Rutgers, Desarrollamos un método para detectar diferentes individuos en una secuencia de video y reconocerlos si se van y luego vuelven a ingresar al video, incluso si se ven muy diferentes. Para hacer esto, Primero creamos tracklets para las personas presentes en el video. Los tracklets se basan en la co-ocurrencia de múltiples partes del cuerpo (cara, cabeza y los hombros, parte superior del cuerpo, y todo el cuerpo) para que las personas puedan ser rastreadas incluso cuando no estén completamente a la vista de la cámara (por ejemplo, sus rostros están volteados u ocluidos por otros objetos). Formulamos el problema de seguimiento de varias personas como una estructura gráfica G =(ν, ε) con dos tipos de aristas:εs y εt. Los bordes espaciales εs denotan las conexiones de diferentes partes del cuerpo de un candidato dentro de un marco y se utilizan para generar el estado hipotético de un candidato. Los bordes temporales εt denotan las conexiones de las mismas partes del cuerpo sobre marcos adyacentes y se utilizan para estimar el estado de cada persona individual en diferentes marcos. Generamos tracklets faciales usando cuadros delimitadores de rostros de los tracklets de cada persona individual y extraemos rasgos faciales para agruparlos.

La segunda parte del método conecta tracklets que pertenecen a la misma persona. La Figura 1 (b) muestra la visualización 2-D tSNE de la característica de cara de VGG extraída en un video musical. Muestra que, en comparación con todas las funciones (b1), característica de las imágenes grandes (b) son más discriminativas. Construimos conexiones inequívocas entre tracklets analizando la resolución de la imagen de la cara de los objetos y las distancias relativas de las características profundas extraídas. Este paso genera un resultado de agrupamiento inicial. Los estudios empíricos muestran que los modelos basados en CNN son sensibles a las imágenes borrosas y al ruido porque las redes generalmente están capacitadas con imágenes de alta calidad. Generamos resultados robustos de agrupamiento final mediante el uso de un modelo de proceso gaussiano (GP) para compensar las profundas limitaciones de las características y capturar la riqueza de los datos. A diferencia de los enfoques basados en CNN, Los modelos GP proporcionan un enfoque paramétrico flexible para capturar la no linealidad y la correlación espacio-temporal del sistema subyacente. Por lo tanto, es una herramienta atractiva para combinar con el enfoque basado en CNN para reducir aún más la dimensión sin perder información espacio-temporal compleja e importante. Aplicamos el modelo GP para detectar valores atípicos, eliminar las conexiones entre valores atípicos y otros tracklets, y luego reasignar los valores atípicos a los clústeres refinados formados después de desconectar los valores atípicos, produciendo clústeres de alta calidad.

Seguimiento de múltiples caras en videos musicales

Para evaluar el desempeño de nuestro enfoque, lo comparamos con métodos de vanguardia para analizar conjuntos de datos desafiantes de videos sin restricciones. En una serie de experimentos, usamos videos musicales, que cuentan con una alta calidad de imagen pero significativa, cambios rápidos de escena, configuración de la cámara, movimiento de la cámara, maquillaje, y accesorios (como anteojos). Nuestro algoritmo superó a otros métodos con respecto a la precisión y el seguimiento de la agrupación en clústeres. La pureza de la agrupación fue sustancialmente mejor con nuestro algoritmo en comparación con los otros métodos (0,86 para nuestro algoritmo frente a 0,56 para el competidor más cercano que utiliza uno de los videos musicales). Además, nuestro método determina automáticamente el número de personas, o racimos, para ser rastreado sin la necesidad de un análisis de video manual.

El rendimiento de seguimiento de nuestro algoritmo también fue superior a los métodos de vanguardia para la mayoría de las métricas, incluyendo recuperación y precisión. Nuestro método aumentó notablemente la mayoría de los rastreados (MT) y redujo las instancias de cambio de identidad (IDS) y fragmentos de rastreo (Frag). El siguiente video muestra resultados de seguimiento de muestra en varios videos musicales. Nuestro algoritmo rastrea a varias personas de manera confiable en diferentes tomas en todos los videos sin restricciones, aunque algunas personas tienen una apariencia facial muy similar, varios cantantes principales aparecen en un fondo desordenado lleno de público, o algunos rostros están muy ocluidos. Este marco para el seguimiento de múltiples caras en video sin restricciones es un paso importante para mejorar la comprensión del video. El algoritmo y su rendimiento se describen con más detalle en nuestro documento CVPR, "Un método sin precedentes para el seguimiento de múltiples caras en videos sin restricciones".

Esta historia se vuelve a publicar por cortesía de IBM Research. Lea la historia original aquí.