Crédito:OpenAI

Bien, Tanto para una suposición que ahora parece demasiado fácil de aceptar:que el magnífico cerebro humano lo tiene sobre una máquina cualquier día. ¿En serio? ¿Interpretamos el mundo con mayor precisión que una "red neuronal convolucional"?

Como señaló Even Ackerman, "cuando una CNN [red neuronal convolucional] se presenta con una imagen, está mirando una cuadrícula estática de píxeles rectangulares ".

Miramos imágenes y las vemos correctamente, como humanos y animales; Las CNN ven las cosas más como computadoras.

Un equipo de investigación está planteando preguntas sobre suposiciones fáciles, sin embargo. Están explorando lo que sucede con los ejemplos contradictorios con respecto a los humanos.

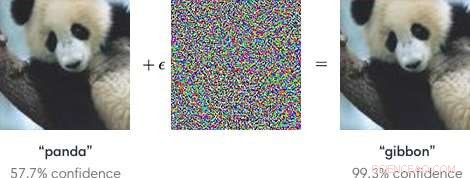

Las entradas a los modelos de aprendizaje automático diseñadas para hacer que los modelos cometan un error son "ejemplos contradictorios". Ejemplos de adversarios, como tal, potencialmente podría ser peligroso.

Simplemente pon, "Los ejemplos contradictorios son entradas maliciosas diseñadas para engañar a los modelos de aprendizaje automático, "según una página de investigación de Google.

Como se explica en una publicación de blog en OpenAI, Los atacantes podrían apuntar a los vehículos autónomos mediante el uso de pegatinas o pintura para crear una señal de alto contradictoria que el vehículo interpretaría como una señal de "ceder el paso" u otra señal.

Los investigadores, al hablar de los modelos de aprendizaje automático como vulnerables a los ejemplos contradictorios, señaló que pequeños cambios en las imágenes pueden hacer que los modelos de visión por computadora cometan errores, como identificar un autobús escolar como un avestruz.

El blog de OpenAI se refirió a los ejemplos contradictorios como representativos de un problema concreto en la seguridad de la IA.

Una vez dicho esto, ¿Qué pasa con los ejemplos de adversarios que engañan a los humanos? ¿Puede pasar eso?

El equipo, dijo Even Ackerman en Espectro IEEE , "Decidí tratar de averiguar si las mismas técnicas que engañan a las redes neuronales artificiales también pueden engañar a las redes neuronales biológicas dentro de nuestras cabezas".

El artículo de investigación que describe su trabajo es "Ejemplos de adversarios que engañan tanto a la visión humana como a la informática, "en arXiv.

"Aquí, Creamos los primeros ejemplos de confrontación diseñados para engañar a los humanos, "escribieron. Descubrieron que" los ejemplos contradictorios que se transfieren fuertemente a través de los modelos de visión por computadora influyen en las clasificaciones hechas por observadores humanos con tiempo limitado ". (Ackerman señaló que en el estudio, las personas solo tenían entre 60 y 70 milisegundos para mirar cada imagen y tomar una decisión).

Espectro IEEE Even Ackerman habló sobre lo que hicieron y presentó un conjunto de dos imágenes de Google Brain para respaldar su explicación.

Ackerman mostró "una imagen de un gato a la izquierda. A la derecha, ¿Puedes decir si es una foto del mismo gato? o una foto de un perro de aspecto similar? La diferencia entre las dos imágenes es que la de la derecha ha sido modificada un poco por un algoritmo para dificultar que un tipo de modelo de computadora llamado red neuronal convolucional (CNN) pueda decir lo que realmente es. En este caso, la CNN cree que está mirando a un perro en lugar de a un gato, pero lo notable es que la mayoría de la gente piensa lo mismo ".

¿Qué? ¿Cómo pueden los humanos cometer el mismo error? Ackerman dijo que podría ser posible enfocar el desarrollo de una imagen de adversario en humanos "eligiendo modelos que coincidan lo más posible con el sistema visual humano".

Pero, ¿qué es exactamente interferir con la capacidad del ser humano para estar en lo correcto? Ackerman dijo que los investigadores señalaron que "nuestros ejemplos contradictorios están diseñados para engañar a la percepción humana, por lo que debemos tener cuidado al utilizar la percepción humana subjetiva para comprender cómo funcionan ".

Dijo que estaban dispuestos a hacer algunas generalizaciones "sobre algunas categorías diferentes de modificaciones, incluyendo 'interrumpir los bordes de los objetos, especialmente por modulaciones de frecuencia media perpendiculares al borde; mejorar los bordes aumentando el contraste y creando límites de textura; modificar la textura; y aprovechando las regiones oscuras de la imagen, donde la magnitud de percepción de pequeñas perturbaciones puede ser mayor '".

Cómo evaluaron:Participaron en el experimento sujetos con visión normal o corregida.

"Para cada grupo, una imagen de adversario exitosa pudo engañar a la gente para que eligiera al miembro equivocado del grupo, identificándolo como un perro cuando en realidad es un gato, o viceversa, "Dijo Ackerman.

Se pidió a los sujetos que clasificaran las imágenes que aparecían en la pantalla presionando botones en un cuadro de tiempo de respuesta, dijeron los autores.

Ackerman escribió:"El poco tiempo que se mostró la imagen mitigó la diferencia entre cómo las CNN perciben el mundo y cómo lo hacen los humanos".

El experimento involucró tres grupos de imágenes:mascotas (perros y gatos), verduras (coles y brócoli), y "peligro" (arañas y serpientes).

El comentario de Ackerman sobre los hallazgos de la investigación fue que "existe una superposición entre la manipulación perceptiva de las CNN y la manipulación de los humanos. Significa que las técnicas de aprendizaje automático podrían usarse para alterar sutilmente cosas como imágenes o videos de una manera que podría cambiar nuestra percepción de (y reacción a) ellos sin que nos diéramos cuenta de lo que estaba pasando ".

Añadió que "tendremos que tener cuidado, and keep in mind that just like those computers, sometimes we're far too easy to fool."

"Adversarial Examples that Fool both Human and Computer Vision" is by Gamaleldin F. Elsayed, Shreya Shankar, Brian Cheung, Nicolas Papernot, Alex Kurakin, Ian Goodfellow, and Jascha Sohl-Dickstein, on arXiv.

© 2018 Tech Xplore